Nicht nur Drummer kennen das nervöse Trommeln, das man zum Zeitvertreib am Küchentisch von sich gibt. Gäbe es doch nur eine App, mit der sich der Klang der Tischplatte zu Percussion-Sounds zaubern lassen könnte. Gibt’s nicht? Gibt es! Mit Objeq hat der kanadische Software-Hersteller AAS (Applied Acoustics Systems) eine iOS-App entwickelt, die das iPhone oder iPad zum tragbaren Trigger macht.

Dadurch wird jeder Gegenstand auditiv in ein Percussion-Instrument verwandelt, und zwar nicht durch den Einsatz von Samples, sondern mittels Physical Modeling. Darüber hinaus ist Objeq über sämtliche iOS-Schnittstellen mit weiteren Apps und DAWs kompatibel, was auch andere Quellen als Trigger-Input erlaubt. Mit Chromaphone 2 haben die Herrschaften von AAS bereits in der Vergangenheit gezeigt, wie authentisch und vielseitig Physical Modeling klingen kann. Ob ihnen das mit Objeq ebenfalls gelungen ist?

Details

Kompatibilität und Verfügbarkeit

Die App erfordert mindestens iOS 11 und ist kompatibel mit iPhone 5s oder neuer sowie iPad Air oder neuer. Objeq ist für 4,49 Euro im App Store als Universal-App erhältlich – wer die App einmal erworben hat, kann sie mit demselben Account daher auf beiden Geräten nutzen. Unterstützt werden Audiobus, Inter-App-Audio und AUv3, wodurch die App über die gängigen aktuellen iOS-Schnittstellen in Garageband, Cubasis und Co. eingebunden werden kann. Dadurch lassen sich auch deren Klangerzeuger und MIDI-Grooves nutzen, um Objeq zu triggern.

Konzept

Zur Klangerzeugung dienen die drei sogenannten Resonatoren Beam, Drumhead und Plate, die jeweils unterschiedliche Materialien und Resonanzkörper mit physikalischer Modellierung nachbilden. Hier werden also keine Samples genutzt, wie es bei Trigger-Plug-ins oder Drum Trigger für gewöhnlich der Fall ist. Vielmehr bilden die Resonatoren Eigenschaften von Instrumenten nach, was auf mathematischer Modellierung physikalischer Vorgänge beruht. Objeq nutzt das Signal, das am internen Mikrofon des iDevice anliegt, und wandelt es live in synthetische Sounds um. Ob das latenzfrei funktioniert, schauen wir uns im Praxisteil an.

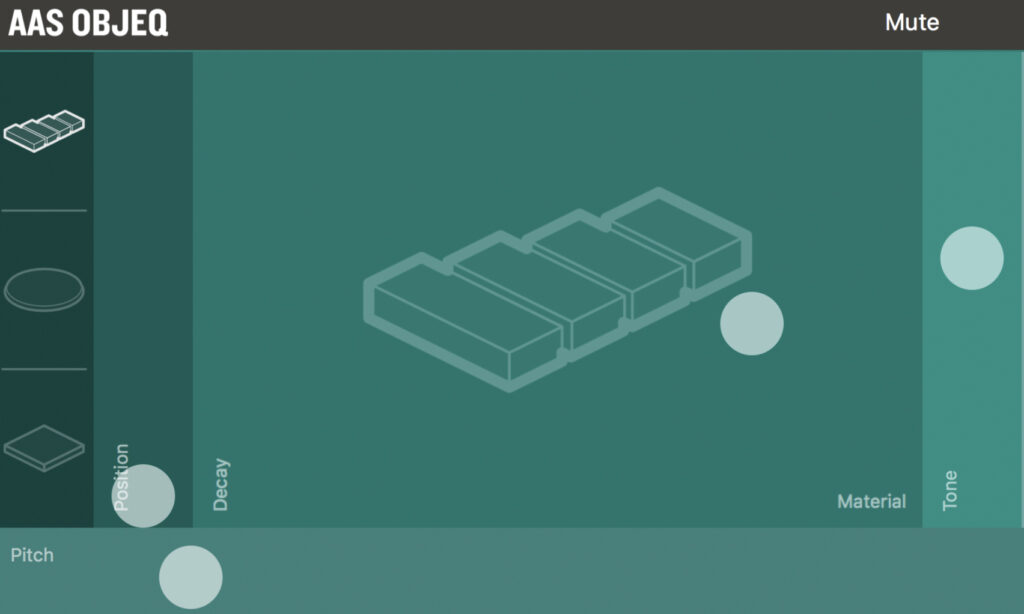

Bedienoberfläche

Das Interface ist simpel gehalten: Auf der linken Seite befinden sich die drei Resonatoren. Wählt man einen der drei aus, ändert sich das physikalische Modell und somit der Grundcharakter der Klangerzeugung. Die Resonatoren verfügen jeweils über vier Parameter. So lässt sich die „Position“ ändern, auf die man virtuell anschlägt, was kleine Klangvariationen ermöglicht – ähnlich unterschiedlicher Anschlagspositionen von Percussion-Instrumenten oder Drums. Mit „Tone“ wird der Attackanteil des Klangs hinzugemischt. Der tonale Anteil dagegen wird auf einem großzügig angeordneten X/Y-Feld mit „Decay“ und „Material“ geregelt. Je mehr man das „Material“ ändert, desto obertonreicher wird das Signal; „Decay“ regelt das Ausklingen des Signals. Hinzu kommt ein Mix-Regler, mit dem das Ausgangsmaterial beibehalten bleiben kann, was sinnvoll ist, wenn man layern anstatt ersetzen möchte.