Schon in den 1950ern wurden Computer zur Erzeugung von Musik eingesetzt, so richtig los ging es aber erst in den 1980er und 1990er Jahren. Auf einmal steckten in den Gehäusen der Synthesizer nicht mehr analoge Schaltkreise, sondern kleine spezialisierte Computer. Kaum wurden Rechner leistungsstark genug, erfolgte die Klangerzeugung direkt in diesen und heute machen Hardware-Synthesizer nur noch einen Bruchteil der Instrumentenproduktion aus. Die digitale Produktion wurde erschwinglich und nicht mehr nur im akademischen Bereich angewendet. Und so ging es vor sich: 1980 wurde noch auf Tonband produziert, im Jahr 2000 nahm ein Tonbandgerät nur wertvollen Studioplatz weg, im Jahr 2021 nimmt ein wertvolles Tonbandgerät den schönsten Platz im Studio ein. Den ersten Teil dieser Geschichte und den wohl radikalsten Wandel in der Musikproduktion überhaupt wollen wir in diesem Teil beleuchten. Und das Zauberwort heißt: Echtzeit.

- Der Einsatz des Computers im akademischen Bereich: Max, CSound, SuperCollider und Konsorten

- Das Heimstudio der 1980er Jahre

- Die Digitale Audio Workstation (DAW)

- Die Echtzeit ist da: Hardware Synthesizer und Chips

- Die Software Synthesizer kommen

- Digitale Synths in Soft- und Hardware heute

- Zum Schluss

Der Einsatz des Computers im akademischen Bereich: Max, CSound, SuperCollider und Konsorten

Kaum gab es Computer wurden sie schon zur Steuerung und Erzeugung von Musik genutzt. Wir erinnern uns: Das elektronische Studio der Columbia University in NYC bekam deren Computer geschenkt, nachdem der nicht wie gewünscht einen Hit nach dem anderen komponierte. Mit Oszillatoren von Bob Moog bestückt wurde dann zeitgenössische klassische Musik darauf komponiert. 1957 schrieb Max Matthews die erste Musiksoftware und der australische CSIRAC Computer sang schon 1960 seine Lieder. Wer sich noch einmal daran erinnern möchte: In Folge #8 unserer Reihe ‚Die Geschichte der elektronischen Musik‘ ging es um die frühesten Versuche der Computermusik von 1950 bis 1970. Allerdings konnten die Töne noch nicht in Echtzeit (engl: real time) von Rechnern generiert werden und auch die Speicherung von Control Daten auf Lochstreifen setzte enge Grenzen.

Außerdem war die Programmierung der frühen Musiksoftware genauso wie die der davon abstammenden Programme wie z. B. CSound aus 1986, SuperCollider aus 1996 und ChucK aus dem Jahr 2003 wenig intuitiv und ähnelt eher der Arbeit eines Softwareentwicklers. So wird ein Sinuston mit 440 Hz mit einer Phase von 0 und einer Lautstärke von 0.5 in SuperCollider so notiert: SinOsc.ar(440, 0, 0.5); Wer daran allerdings Freude haben sollte, ist im Besitz einer unglaublich mächtigen modularen Umgebung, die zumeist sogar kostenlos ist. Die Programme erfreuen sich einer kleinen, aber regen Anhängerschaft und werden bis heute entwickelt und beim live coding auch live auf der Bühne eingesetzt.

Live coding: Alexandra Cárdenas and Olivia Jack

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Für dich ausgesucht

Bedeutend für die Entwicklung des Computers zur Nutzung als echtes Musikinstrument war auch die Forschungsarbeit des IRCAM, dem Institut de Recherche et Coordination Acoustique/Musique, das 1970 gegründet und 1977 eröffnet wurde. Im Gegensatz zu dem schon bestehenden Pariser Studio INA/GRM, von dem wir in Folge #7 schon viel gehört haben, ging es im IRCAM schon immer vor allem um live gespielte Elektronik. Hier wurden schon Ende der 1970er Jahre digitale Klangprozessoren und Workstations entwickelt. 1985 begann hier durch Miller Puckette die Entwicklung von Max, einer ursprünglich für den Macintosh geschriebenen Software, die sich im Unterschied zu den oben genannten Programmen von Anfang an auf eine graphische Benutzeroberfläche konzentrierte. Ein Kästchen mit dem Oszillator, ein Kästchen für den Output, mit der Maus eine Linie gezogen und schon erklang ein Ton.

Oder auch nicht, denn Mitte der 1980er Jahre waren die Computer alleine noch nicht so weit und Max fungierte als Steuerprogramm z. B. von MIDI-Daten und die Klangerzeugung geschah noch auf Geräten wie der Sogitex 4x Workstation oder später auf der von Steve Jobs entwickelten NeXT Plattform. 1997 dann, Max wurde zwischenzeitlich an die Firma Opcode und dann an Cycling `74 lizensiert, erschien die entscheidende Erweiterung, Max/MSP, mit welcher Musik in Echtzeit auf einem haushaltsüblichen Computer erzeugt werden konnte. In dem Namen Max/MSP stecken übrigens sowohl Max Matthews, nachdem das Programm benannt wurde, als auch MSP, was für Max Signal Processing aber auch für Miller Smith Puckette steht. Max, inzwischen in der Version 8 und vielen auch über Max for Live als Erweiterung von Ableton Livebekannt, ist heute eine ungeheuer vielfältige Plattform für die Erzeugung von Steuerungs-, Audio- und Videodaten und wird in vielen Kunst- und Musikprojekten eingesetzt. Bekannt geworden ist der Einsatz von Max z. B. durch Autechre, aber selbst viele Programme zur MIDI-Steuerung auf dem iPad wie Lemur, Touch OSC oder MIDI Designer basieren auf diesem Prinzip. Weitere modulare Audioprogramme die nach demselben Prinzip arbeiten sind AudioMulch, Pure Data, Bidule, ), die Nord Modular und Nord Modular G2 Synthesizer um das Jahr 2000 herum und Reaktor von Native Instruments, auf welche wir später noch zu sprechen kommen werden.

Das Heimstudio der 1980er Jahre

Gehen wir doch einen Schritt zurück und schauen uns das private Heimstudio der 1980er Jahre einmal an. 1981 erschien mit dem IBM PC Model 5150 der erste PC. Der „persönliche“ Computer bezeichnet dabei nur die Größe und die Anwendung durch eine Person im Gegensatz zu den früheren schrankwandgroßen Mainframecomputern. Die Bezeichnung wird zwar oft nur in Verbindung mit Produkten von Microsoft verwendet, gemeint sind jedoch alle Arten von Heimcomputer. Commodore, Atari, Microsoft, IBM, Schneider und Apple fallen ebenso darunter wie MS-DOS, Macintosh, TOS und OS/2. Diese PCs verfügten in den Anfängen meist über nur einen einzelnen Lautsprecher, dessen Aufgabe es war, zu piepsen. Immer in derselben Lautstärke, immer mit dem charakteristischen Sound einer Reckteckwelle, aber immerhin mit verschiedenen Tonhöhen. Beschränkungen machen erfinderisch und so wurde aus diesem einzelnen Lautsprecher alles heraus geholt und das Genre der Chiptunes mit ihrer Pseudopolyphonie in rasantem Tempo wurde erfunden.

Chiptunes lebt – Chiptune Mix 45 von Krelez

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

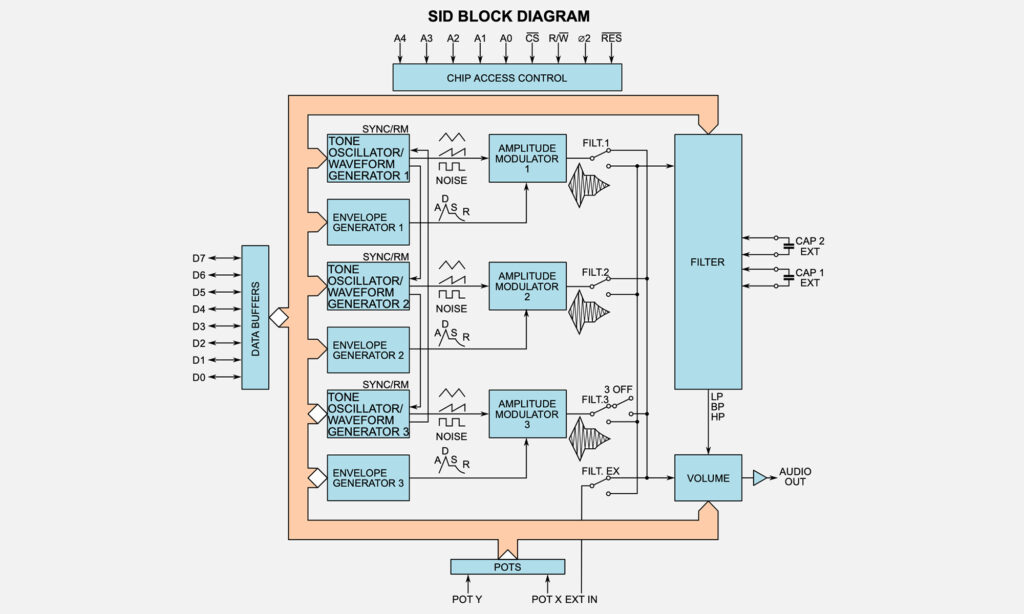

Mehr InformationenAb 1983 und mit der Erfindung von MIDI liefen auf den Computern Rastersequenzer, die sogenannten Tracker. Die Klangerzeugung erfolgte entweder innerhalb der verbauten Chips – auf dem Commodore z. B. durch den SID Chip, ein waschechter miniaturisierter analoger Synthesizer – oder in ausgelagerten Geräten wie dem Moog Song Producer für den Commodore 64, diversen Geräten von Yamaha für die MSX Plattform von Microsoft/ASCII und von Roland gab es beispielsweise die CMU-800 für PC, Apple und Commodore. In diesen Geräten wiederum arbeiteten Soundchips, viel zu viele um sie hier einzeln vorzustellen. Eine gute Auflistung gibt es auf der englischen Wikipedia-Seite. Einige der Chips wurden dabei auch in Synthesizern der Zeit eingesetzt, wie z. B. die Chips von Yamaha und Roland, die sich genauso in deren Hardware Synthesizern fanden. Und selbst, wenn es heute nur digitale Sound Chips gibt, sie machen Musik in Computern, Smartphones, Waschmaschinen und Tablets. Die Welt ist voll von Synthesizern und sie werden im industriellen Standard als Massenware hergestellt. Interessant dabei: In den 1990ern wurde eifrig über die Vor- und Nachteile von Creative Labs Sound Blaster versus Gravis Ultrasound diskutiert. Heute dagegen interessiert sich niemand mehr dafür, welcher Soundchip in welchem Smartphone sitzt.

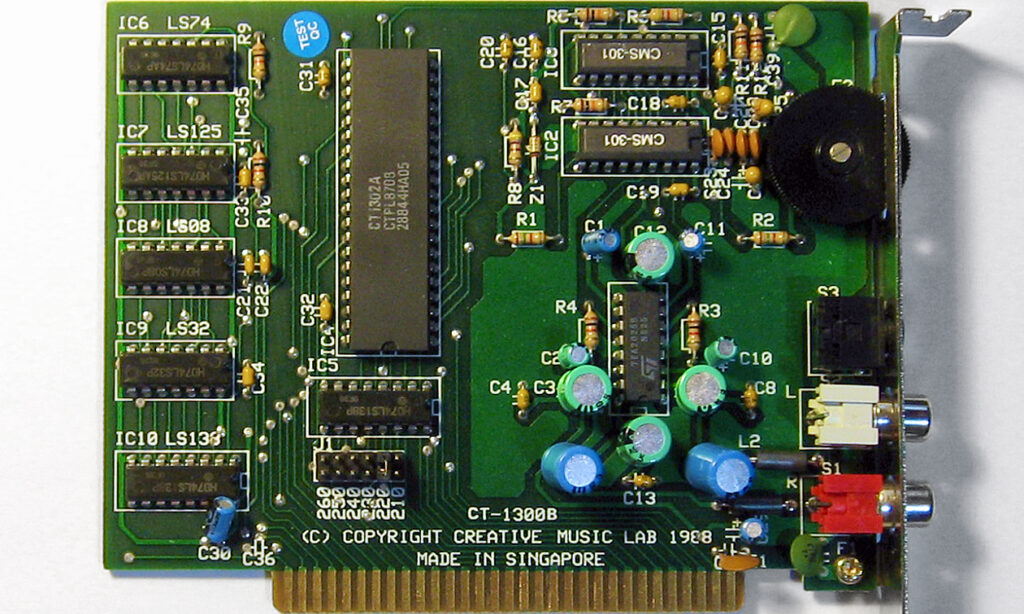

1986 entwickelte Motorola einen Chip, der sich ganz auf die digitale Signalverarbeitung konzentrierte. Digital Signal Processing, kurz DSP, ist nämlich genau das, was zur Errechnung und digitaler Echtzeitgenerierung von Audio sowie Video benötigt und die Motorola DSP56000 Serie kam in Graphik- und Soundkarten, und in vielen Synthesizern zum Einsatz. Dazu später aber noch mehr. 1987 erschien mit Creator von C-Lab ein Notations- und Sequenzer-Programm, das neue Maßstäbe setzte und nicht nur das Ende des traditionellen Notenstichs einläutete, sondern im Zusammenhang mit den DSP Chips gleich auch das Ende des analogen Tonstudios. Als dann 1989 die erste Sound Blaster Karte erschien, wanderte die Klangerzeugung endgültig in den Computer. Natürlich verschwanden die Türme von Rack-Synthesizern nicht gleich und noch lange hatten viele Soundkarten einen MIDI-Port gleich mitinstalliert, aber ein Anfang war gemacht. Wie sich die Technik auf den Klang auswirkte, kann man in diesem Video hier sehr gut nachvollziehen.

Die Titelmelodie von Monkey Island im Wandel der Zeit

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenWer in der Vergangenheit schwelgen oder allgemein mehr darüber wissen will: Eine gute Übersicht zu Technik und Entwicklung der frühen Soundkarten gibt es auf dieser Webseite.

Die Digitale Audio Workstation (DAW)

Arbeiten mit dem Tonband ist mühsam und zeitaufwendig. Und so wurde schon früh nach Wegen gesucht, ob man sich mit digitaler Technik nicht das Leben leichter machen könnte. Vor diesem Hintergrund wurden der Fairlight CMI oder das NED Synclavier erfunden, die auch schon die Idee eines digitalen und tonbandlosen Studios entwickelten. Die Bezeichnung ‚TS‘ beim Synclavier TS steht genau dafür: Tapeless Studio. Und mit genau dem gleichen Schlagwort erschienen 1989 das Digidesign Sound Tools Audiointerface mit dem neuentwickelten Motorola DSP56000 Chip und die Sound Designer II Software auf dem Markt, aus denen zwei Jahre später die DAW Pro Tools werden sollte. Sound Designer II war ein ganz einfacher Audio Editor mit zwei Spuren und ein paar Bearbeitungsmöglichkeiten (Schnitt, Equalizer, Timestretching), aber es war eben viel praktischer zu bedienen als eine Bandschneidemaschine.

Die erste Version von Pro Tools aus 1991 beherrschte dann schon zwei analoge und zwei digitale Ein- und Ausgänge, Pro Tools II TDM aus dem Jahr 1994 lieferte immerhin schon 16 Spuren. Und so ging es immer weiter: Die Anzahl der Spuren wurde ebenso größer wie die Audioqualität besser und die Verarbeitung schneller. Die längste Zeit benötigte Pro Tools dafür dedizierte Audiokarten, bevor 1999 das erste Mal eine reduzierte Pro Tools Variante erschien, die selbst mit ein paar ausgewählten anderen Audiointerfaces arbeiten konnte. 2005 wurde aus dem Audioeditor dann tatsächlich eine selbstständige Produktionssoftware, denn ab diesem Zeitpunkt wurde Pro Tools auch mit eigenständigen Softwareinstrumenten ausgeliefert. Und erst seit 2011 ist mit ProTools 9 die Bindung an bestimmte Audiointerfaces aufgehoben. Das ist also alles noch gar nicht so lange her.

Was wir hier am Beispiel von Pro Tools durchexerziert haben, sehen wir analog auch bei den anderen großen DAWs. Steinbergs Cubase erschien 1989 als MIDI Sequenzer. Cubase wird nach und nach zu einer DAW aufgebohrt, allerdings auf Basis der von Digidesign entwickelten Hardware. 1996 wird die VST-Erweiterung erfunden, mit der man Effekte und Instrumente von Fremdanbietern einbinden kann. Die VST-Erweiterung wird Industriestandard und Cubase hat für eine Weile die Nase vorn. 1999 wird mit Cubase VST 24 3.7 zum ersten Mal ein eigenes virtuelles Instrument mitgeliefert. Der Neon genannte Softsynth liefert zwei Oszillatoren, zwei Envelopes, einen Filter und einen LFO. Heute läuft Cubase genauso wie Pro Tools hardwareunabhängig und ist eine ausgewachsene Produktionsanwendung.

Der dritte im Bunde ist Logic von Emagic, das 1993 erscheint. Auch hier beruht die Technik auf den Entwicklungen von Digidesign und auch hier erscheinen 1999 die ersten virtuellen Instrumente. Mit dem Verkauf an Apple im Jahr 2002 entsteht das Logic von heute, dessen Herkunft man aber noch an den Softsynths von Emagic und vor allem an deren GUI aus der Zeit der letzten Jahrtausendwende erkennt, in welcher Computer immer noch ein bisschen Science-Fiction-Feeling ausstrahlten. Apple holt aus seiner Akquisition viel heraus: Sowohl GarageBand als auch MainStage sind Abkömmlinge von Logic

Die Geschichte aller dieser DAWs ähnelt sich also: Um 1990 als einfaches Schnittprogramm, Sequenzer oder Notensatzprogramm kamen auf, es fand eine allmähliche Erhöhung der Spuren und der Klangqualität statt und Ende der 1990er begann die Entwicklung von Softsynths. Ab 2000 haben wir es bei DAWs mit vollausgereiften Produktionsstudios zu tun und spätestens ab 2010 erfolgt die Loslösung von dedizierter Hardware. Heute ähneln sich DAWs im Funktionsumfang, unterscheiden sich aber im Workflow. Und inzwischen gibt es natürlich noch viel mehr Programme: Bitwig, Studio One, FL Studio und Reaper sind hier nur die bekanntesten. Eine Besonderheit stellt aber vielleicht immer noch Ableton Live dar, das 2001 erschien. Ableton Live war die längste Zeit eine Software, die im Gegensatz zu den üblichen DAWs für – Überraschung! – den Live-Einsatz entwickelt wurde. Zum großen Erstaunen aller konnten bei Ableton Live Audiodateien während des Spielbetriebs ausgetauscht werden, was etwas war, das so überhaupt nicht mit dem Tonbandschnittparadigma der anderen DAWs zusammenging. Heute bietet Live den gleichen Umfang wie seine Kollegen, der Fokus auf den Liveeinsatz ist aber in der DNA verwurzelt und ein Alleinstellungsmerkmal.

Die Echtzeit ist da: Hardware Synthesizer und Chips

Fast unbemerkt haben wir weiter oben, als wir alle Soundchips zu Synthesizern erklärten, den Begriff des Synthesizers aufgebrochen. Aber das ist nur die eine Hälfte der Revolution, die andere besteht darin, dass die Synthesizer zu Computern wurden und das auf seltsame Weise gleichzeitig überdeutlich und unbemerkt. Denn als der Yamaha DX7 1983 erschien, war einerseits ganz klar, dass man es mit einem digitalen Gerät zu tun hat, andererseits wäre niemand auf die Idee gekommen, ihn als VST in a box zu bezeichnen und das nicht nur, weil es VSTs noch gar nicht gab. Einem DX7 spricht niemand ab, ein Instrument zu sein, bei neuen digitalen Synthesizern hört man dagegen oft, dass es ja „nur“ ein Computer sei. Was hat es damit auf sich? Schauen wir uns die dahinterstehende Technik und damit das Herzstück eines jeden Computers an: Den Chip. In einem Yamaha DX7 arbeiten ASICs. ASIC steht für application-specific integrated circuit. Zu Deutsch: Anwendungsspezifische integrierte Schaltung, was es jetzt nicht viel deutlicher macht. Tatsächlich handelt es sich dabei um custom chips, also speziell hergestellte Chips, die teuer in der Herstellung waren. Nur Yamaha und Roland hatten eine eigene Chipproduktion, die kleineren Anbieter kaufen bei den Chipherstellern von der Stange.

In den analogen Zeiten waren das eben die bekannten SSM, CEM und SID Chips mit miniaturisierter analoger Klangerzeugung. Im DX7 und frühen Soundkarten auch anderer Firmen werkelten dagegen oft die OPL2 und OPL3 Chips von Yamaha. Diese Chips generieren den Klang mithilfe von in den Chips gespeicherten trigonometrischen Tabellen, deren Werte ausgelesen und in Spannung umgesetzt werden. Der erforderliche Rechenaufwand hält sich dabei sehr in Grenzen, bei der Klangerzeugung im DX7 muss noch nicht einmal multipliziert werden. Und schließlich tauchten die DSP Chips auf, bei denen der Chip selber die gewünschten Wellenformen in Echtzeit berechnet, was noch einmal ganz andere Ansprüche an die Rechenleistung stellt. DSP Chips wurden von vielen Firmen hergestellt und im Markt der Synthesizer wurden vor allem Produkte von Motorola, Texas Instruments und Sharc eingesetzt. Allein der Motorola 56303 wurde in Nord Modular und Lead, Access Virus, Creamware Synths, Korg Oasys und Radias, Waldorf Q und vielen anderen Geräten verbaut wurde.

Mit den analogen Chips war vornehmlichsubtraktive Synthese möglich, mit den Chips von Yamaha nur FM-Synthese, aber mit den DSP Chips standen plötzlich alle Türen offen. Und so kam es zu einer ganzen Explosion an neuen Synthesearten in den 1980er und 1990er Jahren wie wir sie in Folge #15 unserer Serie bereits besprochen haben. Zwei Syntheseformen fehlen aber noch, die besonders und einflussreich die Entwicklung beeinflussten: Physical Modeling und virtuell analog. Physical Modeling errechnet die Eigenschaften „echter“ Musikinstrumente und bringt das Ergebnis zum Klingen. Man erstellt also ein physikalisches Modell von einer Marimba, schlägt mit einem physikalischen Modell eines Schlegels darauf und bringt so den virtuellen Holzklangstab der Marimba zum Schwingen. Je nachdem, wie der virtuelle Schlegel auf den virtuellen Klangstab auftrifft, verändert sich die Schwingung.

Und wie in der Realität gibt die virtuelle Marimba einen virtuellen Ton von sich, der berechnet und hörbar gemacht werden kann. Interessant für die Klangsynthese wird es aber dann, wenn man verschiedene Teile von verschiedenen Musikinstrumenten miteinander kombiniert und das wurde Mitte der 1990er Jahre mit dem Yamaha VL1 und VL7 (1994), dem Technics WSA1 (1995) und dem Korg Prophecy (1995) ausprobiert. Die dahinterstehenden Patente kamen übrigens wie schon bei der FM-Synthese von der Standford University, die sich einen weiteren Geldsegen aus der Zusammenarbeit mit Yamaha erhoffte. Die wirklich innovativen Instrumente waren allerdings keine echten Erfolge, denn den neuerstellten Instrumenten geht es oft ein bisschen wie dem genauso zusammengestöpselten Frankenstein: Man erkennt was es ist, aber hübsch ist es nicht. Die vielversprechende Syntheseart ist damit leider nicht so mühelos erlernbar, wie es den Anschein macht.

Die virtuell analoge Klangerzeugung hat dagegen ganz mit der Renaissance der analogen Synthesizer zu tun, und das auf geradezu absurde Weise: Anstatt tatsächlich analoge Synthesizer zu bauen, wurden digitale Synthesizer gebaut, die analoge Synthesizer simulieren. Vorreiter war dabei der schwedische Hersteller Clavia mit dem Nord Lead von 1995, dessen letzte Inkarnation seit 2014 als Nord Lead A1 in den Läden steht. Nachdem Folientaster und Jog-Wheels seit dem Yamaha DX7 das Interface Design beherrschten, sah man sich hier einem recht einfachen Synthesizer gegenüber, der aber wenigstens viele Regler und Knöpfe besaß und die allgemein gut verständliche subtraktive Synthese beherrschte. Es war ein Instrument, das endlich mal wieder richtig bespielt werden konnte. 1997 öffneten sich dann die Schleusentore und es erscheinen allein in jenem Jahr der Nord Lead 2, der Access Virus, der Yamaha AN1X und der Roland JP-8000. Bis heute nehmen die virtuell analogen Synthesizer mit klassischer subtraktiver Synthese einen großen Teil im Marktgeschehen ein.

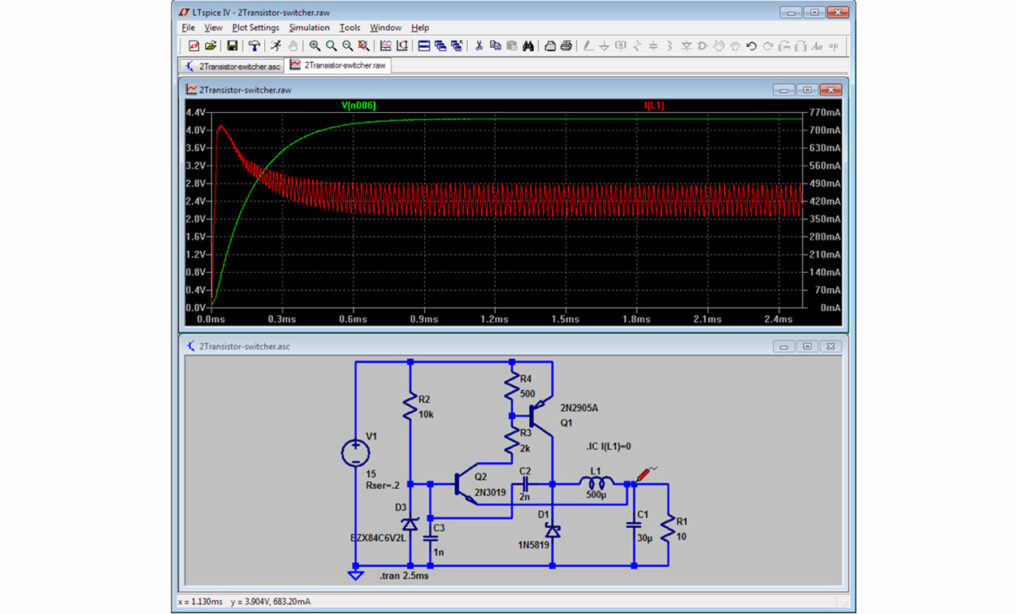

Die tatsächliche Klangerzeugung bei den virtuell analogen Synthesizern ist recht unterschiedlich. Bei manchen wird der Oszillator mit mathematischen Formeln berechnet (direct digital synthesis), die dann vielleicht noch ein wenig angeschmutzt werden, damit es analoger klingt. Oder vielleicht auch nicht, denn es gibt ja auch Anwendungen, wo man besonders saubere Oszillatoren benötigt. So lässt sich richtig saubere Ringmodulation nur mit direct digital synthesis erzeugen. Andere basieren einfach auf Samples analoger Geräte wie z. B. der iVCS von Apesoft für iOS. Die letzte Entwicklung nennt sich circuit modeling und simuliert tatsächlich elektrische Schaltkreise ähnlich wie physical modeling physikalische Musikinstrumente nachmodelliert. Das beruht auf der gleichen Grundlage wie Software, wie sie zum Entwickeln und Testen elektronischer Schaltkreise verwendet wird.

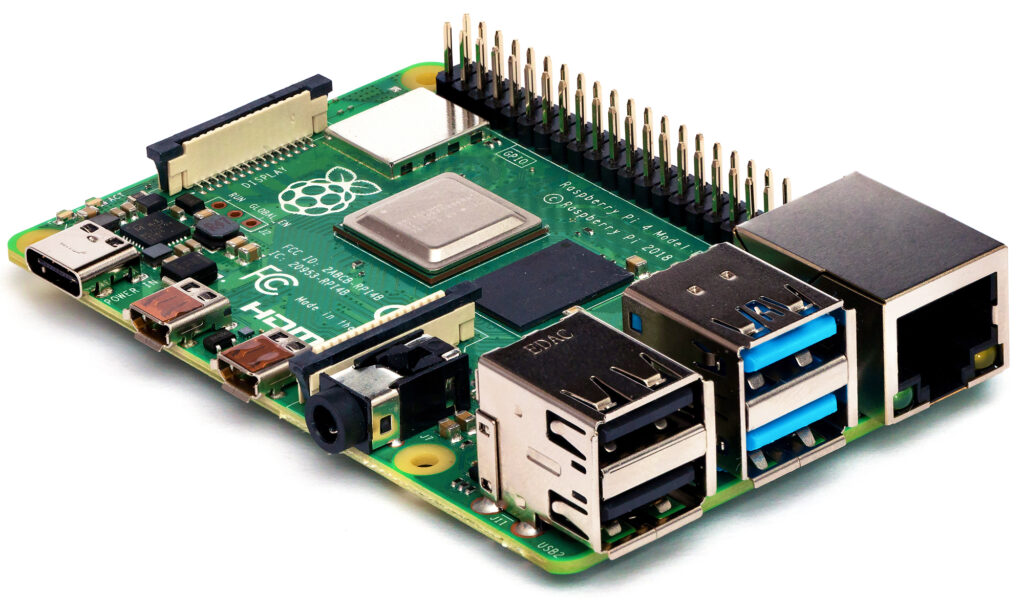

LTspice ist ein bekanntes Beispiel für eine solche Schaltungssimulationssoftware. Aber es gibt einen Haken an der Sache, denn die Rechenpower unserer heutigen Computer ist noch nicht in der Lage, elektronische Schaltkreise in Echtzeit zu berechnen. Man behilft sich, indem man vereinfachte Modelle verwendet und schaut, wo man Rechenleistung einsparen kann. Früher hat man das besonders gut an den Filtern gehört, heute am ehesten an Modulationen im Audiobereich von Oszillatoren und Filtern. Für das circuit modeling sind die alten DSP Chips übrigens gar nicht mehr das Mittel der Wahl, dazu sind sie heute schlicht zu langsam. Schon billige Cortex-A CPUs, wie sie z. B. in einem Raspberry Pi verbaut sind, graben den alten DSP Chips das Wasser ab. Ganz zu schweigen von den CPUs, wie sie in modernen PCs verbaut sind. Und damit sind wir wieder bei den Softsynths angelangt.

Die Software Synthesizer kommen

1997 war nämlich nicht nur das Jahr, in dem viele bekannte virtuell analoge Hardware Synthesizer auf DSP-Basis herauskamen, sondern die Zeit (oder eben die Technik) war inzwischen auch reif für Synthesizer, die auf den hauseigenen Rechnern liefen. Schon ein Jahr vorher zeigte Stephan Schmitt von Native Instruments den Prototypen der Software, die später Reaktor hieß, auf der Frankfurter Musikmesse. Und das kleine Wunder stand auf zwei Beinen: Nicht nur, dass es in Echtzeit lief und sich sofort spielen ließ, es lief auch noch nativ auf einem Windows Computer mit einem handelsüblichen Pentium Chip. Ein natives Instrument, meine Damen und Herren. Aber nicht nur einen Prototyp, sondern einen richtig fähigen Synthesizer entwickelte die amerikanische Firma Seer Systems im folgenden Jahr.

Hier arbeitete inzwischen ein gewisser Dave Smithund 1997 erschien der erste erfolgreiche kommerzielle Softwaresynthesizer, der in Echtzeit spielen konnte: Der Seer Systems Reality. Klar gab es auch schon vorher die Möglichkeit, eigene Sounds auf dem Computer zu erzeugen, und zwar in dem man einen Klang erstellte, auf den „Synthesize“-Button klickte um dann den Klang als Wavefile zu speichern. Der Reality spielte aber in Echtzeit wie ein wirkliches Instrument und war zudem ein kompletter Synthesizer mit fünf Synthesearten: Sampling, virtuell analog, FM, und zwei Arten von physical modeling. Und das lief auf ganz normalen PCs, auch wenn die mit möglichst guten Werten ausgestattet sein sollten. Theoretisch war der Reality 64-fach polyphon und 16-fach multitimbral, aber es war bereits damals schon so wie heute: Die Rechenleistung des Computers bestimmte die tatsächlichen Fähigkeiten.

Seer Music Reality Demo von 1999

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen1997 erschien auch Propellerheads ReBirth RB-338 und diese Emulation zweier Roland TB-303, einer TR-808 und einer TR-909 wurde ein ziemlich großer Hit. Und danach gab es kein Halten, der Markt der Softsynthesizer war eröffnet. Allein von Emagic wurden zwischen 1999 und 2003 zwei Synthesizer, ein Fender Rhodes, ein weiteres E-Piano, ein Sampler, ein Sample Player, eine Hammond B3, einer Hohner Clavinet und ein Vocoder veröffentlicht. 2001 erschien Ableton Live, 2002 brachte Native Instruments die B4, Kontaktund Battery auf den Markt. 2003 erschien der Hartmann und Neuron und 2004 die Korg Legacy Collection – das war die mit dem USB-Controller im MS-20 Look. 2006 erblickte das virtuelle Klavier Pianoteq von Moddart und der Creamware Minimax das Licht der Welt, 2007 Massive von Native Instruments und 2008 Spectrasonics Omnisphere. 2009 dann Camel Audio Alchemy, das später in Apples Logic eingegliedert wurde, 2012 die Diva von U-He. Und das sind nur ein paar mehr oder minder willkürliche ausgewählte und bekannte Beispiele. AufKVR sind zurzeit über 17.000 Plugins gelistet. Ich hätte sie gerne alle bis ins Detail beschrieben aber leider, leider fehlt die Zeit.

Digitale Synths in Soft- und Hardware heute

Heute sind wir in einer ziemlich ungewöhnlichen Lage, und das hat auch mit dem analogen Revival zu tun. Denn analoge subtraktive Synthesizer sind das Maß aller Dinge, und auch bei Software Synthesizern besteht die große Mehrzahl aus virtuell analogen subtraktiven Synthesizern. Wie oben erwähnt, gelingt das zurzeit am besten durch die Emulation der elektronischen Schaltkreise und nichts anderes besagen Arturias True Analog Emulation (TAE), Korgs Component Modeling Technology (CMT), Rolands Analog Behavior Modeling (ABM) und Yamahas Analog Physical Modeling (AN) und Analog Circuit Behavior (ACB). Und da gibt es deutliche Fortschritte zwischen den Instrumenten der frühen 2000er und den Instrumenten ab ungefähr dem Jahr 2010. Das Schlagwort heißt hier vor allem zero delay feedback, womit sich der Klang der Filter sehr verbessert hat. Das heißt aber noch lange nicht, dass Synthesizer, die sich nicht der neuesten Programmiertechnik verschrieben haben, schlecht klingen.

Die frühen analog virtuellen Synthesizer wie der Nord Lead 1 oder der Roland JP-8000 sind gesuchte Instrumente, und das nicht, weil es die besten Emulationen analoger Synthesizer sind, die es je gab. Das Gleiche gilt für Software wie der von Creamware oder der B4 von Native Instruments. Rolands aktuelle Emulationen werden klanglich hochgelobt, obwohl sie doch auf ihrem hauseigenen ESC2 Chip von Boss laufen, der entgegen oft gehörter Meinung kein FPGA Chip, sondern ein DSP Chip ist. Überhaupt eignen sich FPGA Chips überhaupt nicht für circuit modeling, aber die Synthesizer mit FPGA Chips wie der Waldorf Kyra, der Novation Peak oder der Udo Audio Super 6 sind fantastisch klingende Instrumente. Es führen also viele Wege nach Rom und tollen Synthesizern und das muss nicht immer die allerbeste Emulation elektrischer Schaltkreise sein. Und wenn es überhaupt nicht um analoge Emulationen geht, sind die kleinen und günstigen Raspberry Pi Computer und Konsorten heute leistungsfähig genug. Gute Beispiele sind dafür die neuen Korg Wavestate, Opsix und Modwave Synthesizer.

Bleibt die Frage, was jetzt eigentlich der Unterschied zwischen einem digitalen Hardware Synthesizer von 1991 und einem von 2021 ist? Nun, vor 30 Jahren konnte die Software noch gar nicht auf einem normalen Rechner laufen. Seither hat es sich umgedreht und die meisten digitalen Hardware Synthesizer von heute, ob virtuell analog oder nicht, können mindestens ebenso gut auf Laptops oder viel kleineren Systemen laufen. Aber ist es das, was ein Hardware- von einem Software Instrument unterscheidet? Wohl kaum. Es sind zwar alles Computer, die wir da mit einer Maus mit dem Finger auf einer Glasscheibe oder mithilfe mechanischer Regler und Fader bedienen, aber wie man ein Gerät verwendet, ist mindestens genauso entscheidend für das Endergebnis wie das Gerät selbst.

Zum Schluss

Und damit sind wir am Ende dieser Folge und haben zum ersten Mal die Jetztzeit erreicht. Und wie wir sehen, gibt es im digitalen Bereich so viele Möglichkeiten wie nie zuvor: Nicht nur, dass durch die digitalen Chips viel mehr Synthesemethoden möglich wurden, es gibt auch allein mehrere Methoden, um analoge Synthesizer zu emulieren. Die perfekte Emulation analoger Synthesizer im Computer scheint dabei heute das große Ziel zu sein, genauso wie es der perfekt emulierte Klavierklang eine Generation vorher war. Aber das Ohr wird bei solchen Übungen ja tatsächlich immer besser und den meisten der damals auch klanglich hochgelobten VSTs um die Jahrtausendwende weint heute kaum jemand mehr eine Träne nach. Was wird die Zukunft bringen? Sicherlich noch besseres circuit modeling, denn da weiß man ja schon wie es geht, allein die Rechner sind noch nicht schnell genug.

Außerdem auch sicher viele kleine kostengünstige Geräte selbst von kleineren Herstellern, denn Rechenpower auf Raspberry Pi und anderen Geräten ist so günstig wie noch nie, reicht aber schon dicke für digitale Synthesizer aus. Auch Tablets werden immer schneller und vielleicht gibt es ja irgendwann wirklich haptisches Feedback auf Glasscheibe, was es ermöglicht, die virtuellen Bedienelemente nicht nur zu sehen, sondern auch zu spüren. Man darf aber bei allen unbegrenzten digitalen Möglichkeiten nicht vergessen, dass sich die Produkte am Ende auch verkaufen müssen. Und so lange ADSR Envelopes und analoge Filterfahrten gefragt sind, werden eben diese hergestellt und keine neuen Konzepte ausprobiert. Diese finden wir dafür auf der Spielwiese der modernen modularen Synthesizer, auf die wir in der nächsten Folge zu sprechen kommen.