Was ist der Unterschied zwischen Audio- und MIDI-Signalen? Was bedeutet es für die konkrete Arbeit mit der DAW? Aufnehmen, bearbeiten, Rückwärts laufen lassen, Tempo ändern – in diesem Workshop zeigen wir euch die wichtigsten Unterschiede und Gemeinsamkeiten der beiden wichtigsten Signaltypen. Für einen besseren Producing-Workflow für alle Einsteiger!

Gerade für Producing-Einsteiger sind Workflows und Funktionen noch nicht ganz klar. Wer herumexperimentiert, Noten im Akkord verschieben oder Clips rückwärts laufen lassen will, sollte den Signaltyp beachten. Denn je nachdem benötigt es verschiedene Herangehensweisen.

Manches ist möglich (Audio rückwärts), manches nicht (MIDI rückwärts), manches nur auf Umwegen (Akkord verändern in Audio-Aufnahme). Je mehr man sich im Arbeitsalltag die Unterschiede bewusst macht, desto besser kann man Entscheidungen treffen, die zum gewünschten Ergebnis führen.

Inhalt

- Audio: analoge Signale

- MIDI: digitale Steuersprache

- Unterschied I: Aufnahme

- Unterschied II: Spuren und grafische Darstellung

- Unterschied III: Tempo- und Tonhöhenänderung

- Unterschied IV: Rechnerbelastung

- Unterschied V: Bearbeitung

- Unterschied VI: Sound austauschen

- Unterschied VII: Artikulation

Audio: analoge Signale

Das Aufnehmen und Bearbeiten von analogen Audio-Signalen ist die Urform des modernen Musikproduzierens. Bei der Aufnahme wird der eintreffende Schall von der Membran im eingesetzten Mikrofon in Wechselstrom gewandelt. Dieser wird dann im Audiointerface oder der internen Soundkarte von einem Analog-Digital-Wandler in digitale Daten gewandelt. Basierend auf der eingestellten Abtastrate (häufig 44.100 Hertz) wird das Signal an ebenso vielen Punkten (also 44100 Mal pro Sekunde) auf seine Amplitude (Lautstärke) abgetastet.

In der DAW wird die Aufnahme auf einer Audio-Spur als Clip mit einer Wellenform dargestellt. Auf dem Rechner wird die Aufnahme in diesem Verfahren zu einer unkomprimierten WAV-Datei gerendert. Abtasten und Umwandeln erzeugt eine große Menge an Daten. Bei einer Abtastrate von 44.100 Hertz und einer Bitrate von 16 Bit in Stereo ist eine Datei bei einer Aufnahmelänge von einer Minute über 10 Megabyte groß!

MIDI: digitale Steuersprache

MIDI ist eine sogenannte Steuersprache, die im Gegensatz zu Audio-Signalen sehr geringe Datenmengen erzeugt. Durch einen Tastendruck MIDI-Controller wird der DAW und damit dem darauf liegenden Instrument ein 3 Byte großes Datenpaket geschickt. In diesen drei Bytes sind MIDI-Befehlstyp, MIDI-Kanal, die Notennummer und die Anschlagsstärke als Informationen enthalten. Es wird also beispielsweise bei sanftem Tastendruck in der Mitte des MIDI-Keyboards „Note On“, „MIDI CH 1“, Note „C3“ und Velocity „40“ an die DAW gesendet. Bei ebenso sanftem Loslassen sendet das Keyboard dann entsprechend „Note Off“, „MIDI CH1“, „C3“ und Release Velocity „38“.

Viele DAWs speichern MIDI-Clips nicht als separate Dateien ab. Meist muss man den gewünschten Clip erst exportieren. Dann landet er als Datei mit der Endung MID auf der Festplatte. Zum Vergleich: Würde man einen ca. einminütigen Song (bei 120 BPM) nur mit MIDI-Noten komponieren und diesen MIDI-Clip exportieren, wäre die daraus resultierende Datei ca. 3 Kilobyte groß. Eine WAV-Datei wäre gut dreihundert Mal größer. Die Datenmenge ist bei MIDI-Signalen also um ein Vielfaches kleiner.

Das Bearbeiten und Verändern von MIDI-Daten für DAWs und Rechner ist also um einiges leichter und flexibler. MIDI-Noten können in der Tonhöhe oder im Raster verschoben, gelöscht, dupliziert oder in ihrer Länge verändert werden, ohne dass die Klangqualität des getriggerten Software Instruments verändert wird. Auch die Geschwindigkeit des DAW-Projekts kann bei der Arbeit mit MIDI-Noten beliebig verändert werden. Außerdem kann man ganz einfach ein anderes Software-Instrument laden, ohne dass sich an der Melodie oder den Akkorden etwas ändert.

Unterschied I: Aufnahme

Schon bei der Aufnahme unterscheiden sich MIDI und Audio sehr. Audio-Signale werden häufig mit einem Mikrofon aufgenommen, bei Hardware-Synthesizern oder Samplern ist es oft ein direkt abgenommenes Line-Signal. Beide, Mikrofon- oder Line-Kabel, sind an ein Audio-Interface angeschlossen. Für eine gut klingende Aufnahme ist man vor allem bei der Aufnahme eines akustischen Instruments per Mikrofon auf sehr viele Faktoren angewiesen. So muss zuallererst das Instrument in guten Zustand sein, also keine nervigen Störgeräusche wie Knacken oder Quietschen beim Spielen erzeugen.

Dazu muss der Raum, in dem aufgenommen wird, akustisch optimiert und möglichst frei von Störgeräuschen wie Straßenverkehr oder lauten Nachbarn sein. Auch bei Mikrofon, Verkabelung und Audio-Interface sollten möglichst hochwertige Modelle eingesetzt werden. Und zu guter Letzt sollte der oder die Musikerin das Instrument möglichst gut beherrschen. Viele Faktoren also, die aber in der Aufnahme eine Musikalität und einen Groove in einen Song bringen können, der mit Produktionen auf MIDI-Basis viel schwerer zu erzeugen ist.

MIDI-Noten sind zwar sehr schnell programmiert oder eingespielt und der Klang vieler Software-Instrumente ist makellos – kein schiefer Ton, kein Quieten. Aber genau da liegt die umgekehrte Herausforderung beim Produzieren. Damit ein Rhythmus, eine Akkordfolge oder eine Melodie nicht zu statisch klingt, muss man sich im Arrangement viel mehr Gedanken machen. Bei der Arbeit mit MIDI und Software-Instrumenten geht es also oft darum, wie man Performance simuliert. Indem man beispielsweise durch Layering, Velocity-Variationen oder Effekt-Automationen aus Plugins das holt, was bei Aufnahmen akustischer Instrumente von vornherein dabei ist.

Andererseits ist die Flexibilität von MIDI-Noten einer der Pluspunkte für viele, die am Anfang des Produzierens stehen. Ganz einfach kann man mit einem Arpeggiator Akkorde zu Melodien umwandeln. Oder mit einem Songwriting-Tool wie Scaler 2 diese Akkorde überhaupt erst erzeugen. Oder blitzschnell ganze Projekte ohne Qualitätsverlust in eine andere Tonart transponieren. Oder ein Instrument Note für Note einspielen.

Unterschied II: Spuren und grafische Darstellung

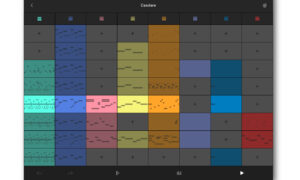

In einigen DAWs liegen MIDI-Clips auf MIDI-Spuren (Ableton Live, Bitwig Studio) – egal ob dort ein Software Instrument gespielt wird oder ein externes Hardware-Instrument. In anderen Programmen wie Logic Pro oder Cubase gibt es Instrument-Spuren und MIDI-Spuren. Erstere sind zum Spielen von VSTs wie Serum oder Pigments da. MIDI-Spuren sind hier vor allem für das Triggern von externer Hardware gedacht. MIDI-Clips sind Minitaturansichten der gespielten oder programmierten MIDI-Noten. Die Bearbeitung findet in der sogenannten Piano-Roll statt. Hier wird links vertikal eine Klaviertastatur angezeigt. Daneben kann man dann im eingestellten Raster MIDI-Noten bearbeiten, setzen, verschieben oder löschen.

Audio-Dateien liegen auf Audio-Spuren. Audio-Clips werden in der DAW als Wellenform dargestellt, die den Lautstärkeverlauf des Audiosignals zeigt. Bei Drum Samples sieht man zum Beispiel am Anfang eine extreme Spitze, den Transient, bevor das Sample ausklingt. Im Gegensatz dazu wird die Wellenform einer Aufnahme von sanft spielenden Streichern langsam höher und fällt am Ende plötzlich ab. Bei Gesang wiederum ist meist eine Folge mehrerer kleiner Blöcke zu sehen, je nachdem, wo lauter oder leiser gesungen wurde. Die Tonhöhe einer Aufnahme wird nicht im Audio-Clip dargestellt. Und das Ablegen eines MIDI-Clips auf einer Audio-Spur und umgekehrt ist in den meisten DAWs nicht möglich

Unterschied III: Tempo- und Tonhöhenänderung

Das Vielfache an Daten in Audio-Dateien ist auch der Grund, warum die nachträgliche Veränderung von Tempo oder Tonhöhe so viel rechenintensiver ist als bei MIDI. Soll beispielsweise ein Audioclip mit einer Klaviermelodie 20 BPM langsamer oder zwei Halbtöne tiefer abgespielt werden, arbeitet im Hintergrund in der DAW deren Timestretching-Algorithmus auf Hochtouren.

Noch komplizierter wird es, wenn man in einer Audio-Aufnahme einer Melodie einen einzelnen Ton oder in einer Orchester-Aufnahme einen Akkord verändern will. Mit Melodyne und Direct Note Access ist das prinzipiell möglich. Der Workflow ist aber nicht eben schnell, die Rechnerbelastung groß und bei altem oder schlecht aufgenommenem Material auch nicht immer erfolgreich.

Umgekehrt spielt es bei MIDI-Noten keine Rolle, wohin man die Noten schieben möchte oder in welchem Tempo sie abspielen sollen. Ob dramatische Verlangsamung oder sehr tiefe oder hohe MIDI-Noten noch gut klingen, hängt nur vom getriggerten Software-Instrument ab. Hier kann man nach Belieben Noten verändern und löschen, sogar gleitende Tempoänderungen in der DAW erzeugen, qualitativ ändert sich nichts.

Tipp: Hat man beim Einspielen von MIDI-Noten Schwierigkeiten eine Melodie oder Akkordfolge fehlerfrei zu spielen, stellt vor der Aufnahme einfach das Projekttempo herunter. Nach der Aufnahme stellt man das Originaltempo wieder ein. Qualitativ wird es keinen Unterschied zu hören geben. So kann man die kompliziertesten Melodien und Akkorde einspielen.

Unterschied IV: Rechnerbelastung

Lässt man Audio-Dateien unberührt, belasten sie heutige CPUs beim reinen Abspielen quasi nicht. Sobald aber der DAW-interne Timestretching-Algorithmus wegen Tempo- oder Tonhöhenveränderung mit dem Audiomaterial arbeitet, kann das bei größeren Projekten den Rechner auch am die Grenzen bringen. Arbeitsspeicher ist wiederum bei der Arbeit mit Audio-Material nicht wichtig. Sobald man aber mit Libraries für Sampler wie Kontakt oder Omnisphere arbeitet, wird dieser ein wichtiger Leistungsfaktor. Denn für einen möglichst flüssigen Workflow werden die Audio-Samples der Libraries zu einem Großteil in den Arbeitsspeicher geladen.

Beim reinen Abspielen von vielen Audio-Dateien gleichzeitig gab es bis vor einigen Jahren noch den Faktor Festplattengeschwindigkeit. Aber heutige SSDs zucken hier, außer bei riesigen DAW-Projekten mit zehntausenden Dateien, nicht mal mit der Wimper. Falls ihr einen älteren Rechner mit langsamerer Festplatte nutzt und viel mit großen Audiodateien arbeitet, kann das eventuell aber noch zu einer Stolperfalle für die DAW werden. Hier kann ein Upgrade auf eine SSD-Festplatte Wunder wirken.

MIDI-Daten selbst sind für Rechner noch einfacher zu verarbeiten als Audiosignale. Allein sind sie aber auch relativ nutzlos. Sie triggern meist Software-Instrumente, die häufig CPUs mit am meisten fordern. Man kennt es vielleicht von Granular-Synth-Sounds in Pigments oder Omnisphere: hier sorgen manchmal schon zwei, drei Noten gleichzeitig für heftiges Knacksen und ausgereizte CPU.

Unterschied V: Bearbeitung

Will man in einem Midi-Clip eine störende Note löschen, ist das mit ein, zwei Mausklicks erledigt. Bei Audiomaterial kommt es sehr darauf an, ob die gewünschte Note möglichst freisteht, also keine Note vorher kam, die zum Anspielzeitpunkt noch ausklingt. Falls das nämlich der Fall ist und man die betreffende Note in der Audiospur ausschneidet, ist dieser Schnitt unschön zu hören.

Ein Problem hat man bei MIDI-Clips für den Fall, das man sie rückwärts laufen lassen will. Bei Audio-Clips ist das ein beliebtes kreatives Stilmittel, ob als „Reversed Cymbal“ für einen Riser-Effekt oder beim kreativen Bearbeiten eines Loops. Technisch gesehen ist rückwärts abspielen bei MIDI-Daten nicht möglich. Sonst käme immer zuerst der „Note off“-Befehl, wenn noch gar keine Note läuft und der „Note On“-Befehl danach. Die getriggerte Note würde nie aufhören. Will man also eine eingespielte MIDI-Sequenz rückwärts abspielen, muss man die entsprechende Spur erst als Audio-Datei exportieren und dann wieder auf eine Audiospur importieren. Einige DAWs bieten das auch automatisiert als „Bounce-in-place“ oder „Render-in-place“ an.

Unterschied VI: Klang verändern

Wer kennt es nicht? Man hat schön die MIDI-Noten gesetzt und dann durch die Presets des Lieblings-VSTs gewechselt, um zu hören, bei welchem die Melodie am besten klingt. Das ist mit Audio-Aufnahmen kaum oder gar nicht möglich. Der Klang eines aufgenommenen Klaviers lässt sich zwar mit entsprechendem Sounddesign verfremden, es gibt aber bisher keinen Effekt und keine Bearbeitungsmöglichkeit, um die Klavieraufnahme beispielsweise wie eine Trompete oder einen Minimoog-Bass klingen zu lassen.

Auf MIDI-Spuren, auf denen MIDI Noten Software-Instrumente triggern, ist das Austauschen des Instruments oder das Wechseln von Presets dagegen ein Leichtes. Und dazu noch eine sehr empfehlenswerte Technik für funktionierende Arrangements. Denn was als Einzelspur noch nach bombastischen Pianoakkorden klang, kann in einem vollen Song-Arrangement untergehen oder der Stimme nicht genug Platz machen. In diesem Fall tauscht man das Piano gegen sanfte Streicher oder einen Pad-Sound und schon fügt sich alles viel besser zusammen.

Unterschied VII: Ausdruck

Wer bisher den Eindruck haben mag, dass MIDI doch eigentlich fast nur Vorteile bietet, dem sei gesagt: fast! Denn einer der größten Einschränkungen, der in der Natur von MIDI liegt, ist der mangelnde Ausdruck. 128 mögliche Anschlagsstärken oder Velocity-Werte mögen für viele Synthesizer noch ausreichend wirken. Ein aufgenommenes, akustisches Instrument wie ein Schlagzeug, ein Klavier oder eine Gitarre hat aber eben unendlich viele unterschiedliche Noten – jeder Schlag und jede Note ist einzigartig.

Dazu ist der Wechsel zwischen unterschiedlichen Artikulationen – entsprechende Übung und Können am Instrument vorausgesetzt – bei Audio-Aufnahmen ein Leichtes. Ob von Legato zu Staccato bei Streichern, ob von Open Chords zu Palm Muted zu Arpeggios bei Gitarren oder von Flams zu Down Strokes zu Ghost Notes bei Drums – diese Wechsel passieren bei geübten Instrumentalisten von ganz allein.

Bei MIDI-Noten artet das Wechseln zwischen verschiedenen Artikulationen in lange Klickstrecken aus – falls die entsprechenden Samples überhaupt im Sample-Instrument dabei sind. Auch sind diese unterschiedlichen Spielarten nicht in MIDI-Noten verankert. Man kann also nicht einfach das Instrument tauchen und die Artikulationen werden dort entsprechend mit gewechselt. MIDI 2.0 soll das zwar ändern, bis es entsprechende Software-Instrumente und einen passenden Workflow in DAWs gibt, wird aber noch etwas Zeit vergehen.

Fazit

Audio- und MIDI-Signale bestimmen den Produktionsalltag. Zwar haben sie einige Gemeinsamkeiten, wichtig sind aber vor allem die Unterschiede. Je deutlicher man sich diese bei der Aufnahme und Nachbearbeitung bewusst macht, desto zielgenauer kann man Entscheidungen im Produktionsprozess treffen: Nehme ich die Gitarre besser auf, um mehr Ausdruck einzufangen? Dann sollte es eine Audio-Aufnahme werden. Wird die Tonhöhe und das Tempo des Projektes vielleicht noch einmal angepasst, weil evtl. die Lage der Vocals nicht passt? Dann sollte man so viel wie möglich in MIDI produzieren. Wer die Unterschiede kennt, wird es beim Producing leichter haben.